Google Assistant, Siri y Alexa son más conocidos por sus voces femeninas que masculinas. Y esto es un problema, según un informe de la ONU, que encuentra que ver a un asistente responder sistemáticamente con una voz femenina refuerza los estereotipos sexistas de que las mujeres deben responder a las órdenes y hacer lo que se les dice sin pestañear.

¿Google, Amazon y Apple ayudan a transmitir clichés sexistas a través de sus respectivos asistentes de voz? En cualquier caso, esta es la conclusión de un informe de la UNESCO (Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura), una de las ramas de las Naciones Unidas. Los autores creen que el hecho de que Google Assistant, Alexa o Siri generalmente tengan una voz femenina “refleja y refuerza” la idea de que el papel de asistentes debe atribuirse a las mujeres.

Asistente de Google, Siri, Alexa: las voces predeterminadas son demasiado a menudo femeninas y refuerzan los clichés según la ONU

El informe se titula "Me sonrojaría si pudiera", que fue una respuesta que Siri dio cuando se le preguntó "¿Eres una perra?". “Debido a que la mayoría de los asistentes de voz usan una voz femenina, envía una señal de que son útiles, dóciles y ansiosos por complacer a los ayudantes, disponibles en cualquier momento con solo presionar un botón o con un comando de voz directo como 'hey' u 'ok'. El asistente no tiene más poder que lo que se le pide. Honra las órdenes y responde a las solicitudes sin importar el tono o el grado de hostilidad. En muchas comunidades, esto refuerza los prejuicios de género generalmente aceptados de que las mujeres son sometidas y tolerantes al abuso ”, denuncia el documento.

Lea también: Altavoces conectados: el Asistente de Google, Alexa y Siri entienden mejor a los hombres que a las mujeres

Los efectos en los niños preocupan especialmente a los investigadores. Calvin Lai, de la Universidad de Harvard, que se especializa en prejuicios inconscientes, explica que “las asociaciones de género que hacen las personas dependen de la frecuencia con la que las personas se exponen a ellas. A medida que aumenta el número de asistentes digitales, la frecuencia y el volumen de asociaciones entre "mujer" y "asistente" aumentan drásticamente ". El profesor Noble agrega que “los comandos que les ladran a los asistentes de voz, como 'buscar x', 'llamar x', 'cambiar x' o 'comando x', actúan como poderosas herramientas de socialización y enseñan a las personas, y en particular a los niños, que el rol de mujeres, niñas y mujeres es satisfacer sus demandas. Representar constantemente a las asistentes digitales como una mujer codifica gradualmente un vínculo entre la voz de la mujer y su sumisión ”.

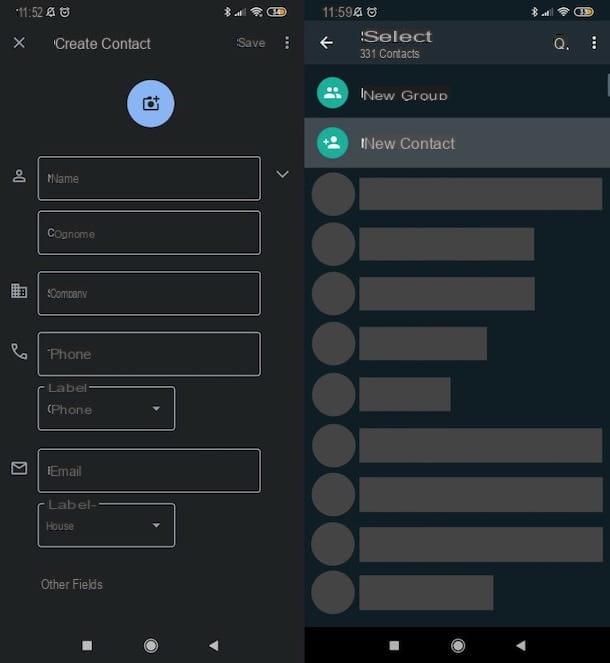

La UNESCO recomienda que los gigantes digitales analicen seriamente el problema y propongan soluciones más adecuadas. Tenga en cuenta que la voz predeterminada de los asistentes puede variar según el idioma. Para Siri, suele ser una voz femenina, pero ahora es una voz masculina en inglés británico, holandés, árabe o español. Alexa por su parte solo tiene derecho a una voz femenina por el momento.